互联网金融公司分布式数据库运维实践 挑战、策略与未来

引言:数字化时代的核心引擎

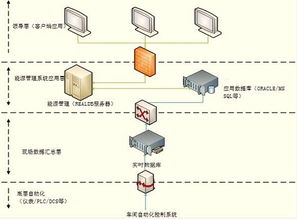

在互联网金融的浪潮中,数据是业务的血液,而数据库则是承载这颗心脏的核心引擎。随着用户规模激增、交易并发量呈指数级增长,传统集中式数据库在性能、扩展性和可用性上已捉襟见肘。分布式数据库凭借其弹性伸缩、高可用和容灾能力,已成为行业技术架构升级的必然选择。从集中式到分布式的转型,不仅是技术的更迭,更是一场深刻的运维理念与实践的重塑。

第一部分:核心挑战与痛点分析

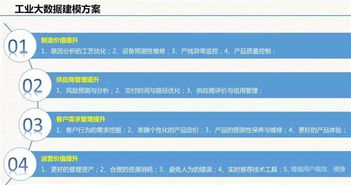

- 数据一致性与高性能的平衡:金融业务对数据的强一致性要求极高,而分布式环境下的跨节点事务、全局一致性(如分布式事务ACID保障)与低延迟、高吞吐的性能目标往往存在天然矛盾。

- 弹性伸缩与成本控制:业务流量存在明显的波峰波谷(如促销、秒杀活动),需要数据库能够快速、平滑地扩缩容。如何实现自动化资源调度,同时避免资源浪费,是运维成本控制的关键。

- 高可用与容灾的复杂性:分布式架构将单点故障风险分散,但也引入了网络分区、脑裂等新风险。构建跨地域、多活容灾体系,确保RTO(恢复时间目标)与RPO(恢复点目标)满足金融级要求(如RPO≈0),复杂度呈几何级数上升。

- 运维监控与故障定位的难度:系统从单体变为分布式网状结构,监控指标爆炸式增长。一次性能抖动或故障,其根因可能隐藏在多个服务、数据库节点与网络链路中,定位与排查如同“大海捞针”。

- 安全与合规的刚性约束:金融数据安全、隐私保护(如《个人信息保护法》)、审计溯源等合规要求,必须在分布式架构的每一个环节(数据分片、传输、存储)中得到严格落实。

第二部分:核心运维策略与实践

- 架构选型与设计先行

- 选型原则:根据业务特征(如OLTP或OLAP倾向、数据模型)选择合适的技术路线(如NewSQL、基于中间件的分库分表)。明确一致性模型(强一致、最终一致)的适用场景。

- 数据分片策略:采用合理的分片键(如用户ID、业务主体ID),避免数据倾斜与热点。设计上预留扩容空间,支持在线数据重分布。

- 自动化运维平台建设

- 资源生命周期管理:通过平台实现实例的自动部署、配置管理、版本升级、扩缩容(如基于预测算法的弹性伸缩),将人工操作降至最低。

- 智能化监控与告警:构建统一的监控大盘,覆盖从硬件、网络、数据库实例到慢查询、事务状态的全链路指标。引入AIOps,实现异常检测、根因分析与智能降噪,变“救火”为“预防”。

- 高可用与容灾体系构建

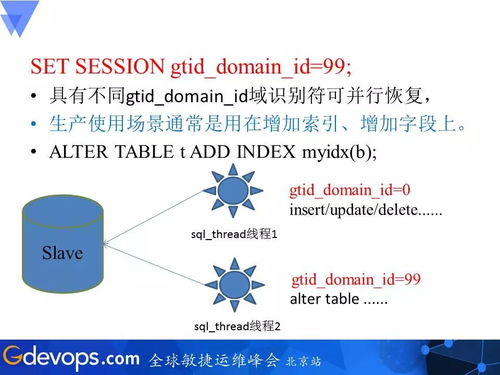

- 同城多活与异地灾备:在同城数据中心内部署多副本,利用Raft/Paxos等共识协议保证高可用。建设异地异步/半同步容灾集群,定期进行灾备演练,确保切换流程可靠、数据完整。

- 混沌工程实践:主动注入故障(如节点宕机、网络延迟、磁盘IO异常),验证系统韧性,持续优化应急预案与恢复流程。

- 性能优化与容量管理

- SQL审核与慢查询治理:建立上线前SQL审核规范,利用执行计划分析、索引优化等手段从源头杜绝性能隐患。对线上慢查询进行实时追踪与优化。

- 容量规划与成本优化:建立精细化的容量模型,基于历史数据与业务预测进行容量规划。利用存储分层、数据冷热分离、闲置资源回收等技术优化存储与计算成本。

- 安全与合规内嵌

- 全链路数据加密:实现数据传输(TLS/SSL)与静态数据加密,严格密钥管理。

- 细粒度访问控制与审计:实施基于角色的最小权限访问原则,所有数据库操作留有完整、不可篡改的审计日志,满足合规审计要求。

第三部分:未来展望与

分布式数据库的运维正朝着平台化、自动化、智能化、安全原生的方向演进。随着云原生、Serverless、人工智能等技术的深度融合,未来的运维将更加聚焦于业务价值交付与SLA保障,而非底层基础设施的琐碎管理。

而言,互联网金融公司的分布式数据库运维实践,是一场以稳定性、效率、成本、安全为四大支柱的持续旅程。它要求技术团队不仅精通数据库技术本身,更要具备全局的架构视野、工程化的平台思维和应对复杂性的系统方法论。唯有将稳健的运维实践深深嵌入到技术体系的骨髓中,方能支撑起互联网金融业务在数字化浪潮中的高速、稳健航行。

如若转载,请注明出处:http://www.nirsiu.com/product/61.html

更新时间:2026-01-12 06:12:46